编译/VR陀螺

英伟达新的AI模型GET3D旨在加快3D内容的创建速度。该模型可以在几秒钟内输出许多纹理的3D网格,可以在标准图形引擎中无缝使用,而这只需要一张2D图像作为输入即可。

GET3D是 " Generate Explicit Textured 3D(生成显性纹理三维)"的缩写,是一种生成性3D模型,可以合成任何拓扑结构的高质量3D多边形网格。一张二维图像就足以作为生成过程的输入。

图源:Nvidia

图源:Nvidia

生成的多边形网格由带纹理的三角形组成,这是一种标准格式,可以无缝导入3D程序、游戏引擎或电影渲染器。

3D对象在导入后是完全可编辑的,例如,可以进行缩放、旋转和照明。通过英伟达的StyleGAN-Nada,开发人员可以进一步改变3D模型的形状或纹理,只需使用文本命令,例如,将传统汽车转变为警车。

从合成的2D图像生成3D模型

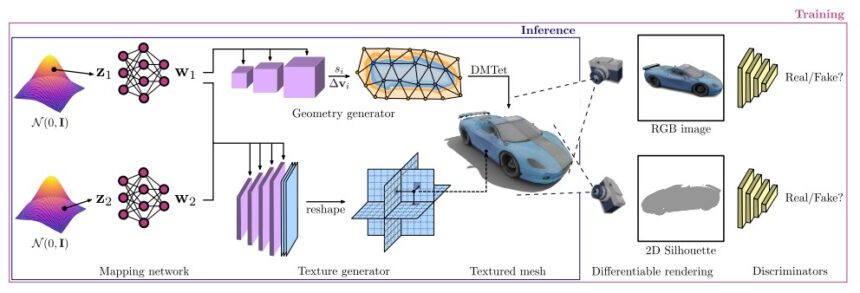

英伟达的研究团队开发了一个两步的生成过程。几何分支生成具有任何所需拓扑结构的多边形网格。纹理分支则会生成一个纹理字段,该字段可以表示颜色,例如,多边形网格表面点处的特定材料。

最后,与GA网络一样,鉴别器根据3D模型的合成照片评估输出的质量,并不断优化它以匹配目标图像。

GET3D是用大约100万张不同角度的3D模型的合成2D图像进行训练的。据英伟达称,在英伟达 A100 GPU上训练需要花费大约2天时间。

GET3D加速了3D内容的进程

GET3D能够生成的3D模型取决于训练数据。例如,如果你用合成的汽车或动物图像训练系统,它可以生成3D汽车或动物。英伟达表示,训练数据集越大、越多样化,生成的3D模型就越详细、越多样化。

图源:Nvidia

图源:Nvidia

据英伟达称,在一个现成的英伟达 GPU上,该模型在训练后每秒可以生成大约20个形状,这些形状组合起来就形成了一个3D模型。生成过程在用户的计算机上进行,因此不受内容限制,如云端人工智能服务中已知的那些限制。

"GET3D使我们离AI驱动3D内容创作的普及化更近了一步,"英伟达在多伦多的研究实验室负责人Sanja Fidler说道,该工具就是在那里开发的。

据英伟达的研究团队称,GET3D的一个限制是,目前只能用已知相机位置的合成图像的2D剪影进行训练。在未来的版本中,相机位置预估的进展可能会成为使用真实图像进行训练的基础。

目前,GET3D也只能按类别进行训练。跨类别的模型可以增加生成的3D模型的种类,提高系统的灵活性。

作为一个开源模型,GET3D可以在Github上免费使用。

来源:mixed-news

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息