编译/VR陀螺

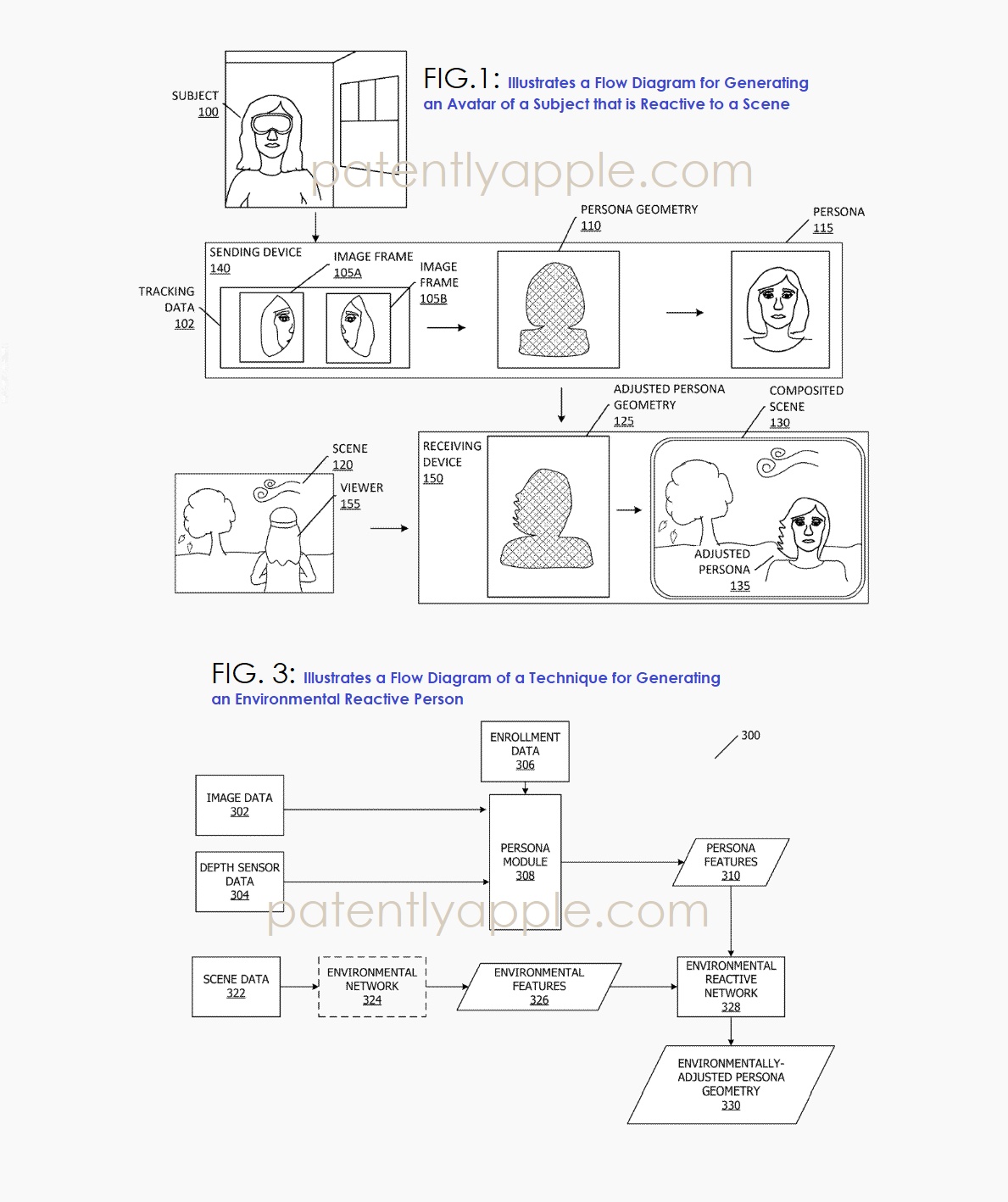

近日,苹果公布了一项新的专利申请,专利提出了一个虚拟化身系统,用户角色能够实时动态地对物理或虚拟环境做出反应。

该系统分几个阶段运行:

• 从用户处捕获跟踪数据(图像帧、深度数据、传感器数据)。

• 使用机器学习模型(例如像素对齐隐函数 (PIFu) 网络、自编码器或 GAN)生成与环境无关的角色几何形状。

• 从将要显示虚拟化身的场景中检测或推断环境特征。

• 调整人物的几何形状和纹理以反映环境条件。

• 在合成场景中实时渲染调整后的角色形象。

最终呈现的数字形象仿佛真实存在于环境中一般。例如,如果观看者身处刮风的户外场景,远程用户的虚拟化身也会随着风的吹拂而动,头发和衣着也会随之变化——即使用户身处室内。

此外,这项专利揭示了苹果正在聚焦的几大领域:

1. 环境驱动的化身几何体。苹果此前一直致力于捕捉精准的面部表情和头部动作(例如FaceTime Personas和Vision Pro Personas)。这项专利更进一步,不仅能根据用户动作,还能根据外部环境因素来调整虚拟化身。

2. 场景相关的物理模拟。该系统能够通过视觉线索(例如飘落的树叶)或传感器数据(例如风力或环境光线)推断环境状况。这比苹果目前的XR框架更进一步,后者主要根据设备运动或用户输入来调整虚拟内容。

3.跨场景角色适应。该专利明确支持用户身处一个环境但其虚拟化身显示在另一个环境中的场景。这是对苹果公司共在模型的一次重大概念扩展。

4. 实时几何调整。该角色的网格或点云会逐帧动态变化。这比目前Vision Pro Persona中使用的静态几何体更加先进。

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息