文/前方智能

苹果在7月30日发布了 iOS 18.1、iPadOS 18.1 和 macOS Sequoia 15.1 的开发者测试版,这个版本最大的变化就是迎来了备受期待的 Apple Intelligence 功能。这也标志着苹果的 AI 不再仅仅停留在 Keynote 阶段,终于向人人都能用上 AI 的方向迈出了第一步。

图源:苹果

图源:苹果

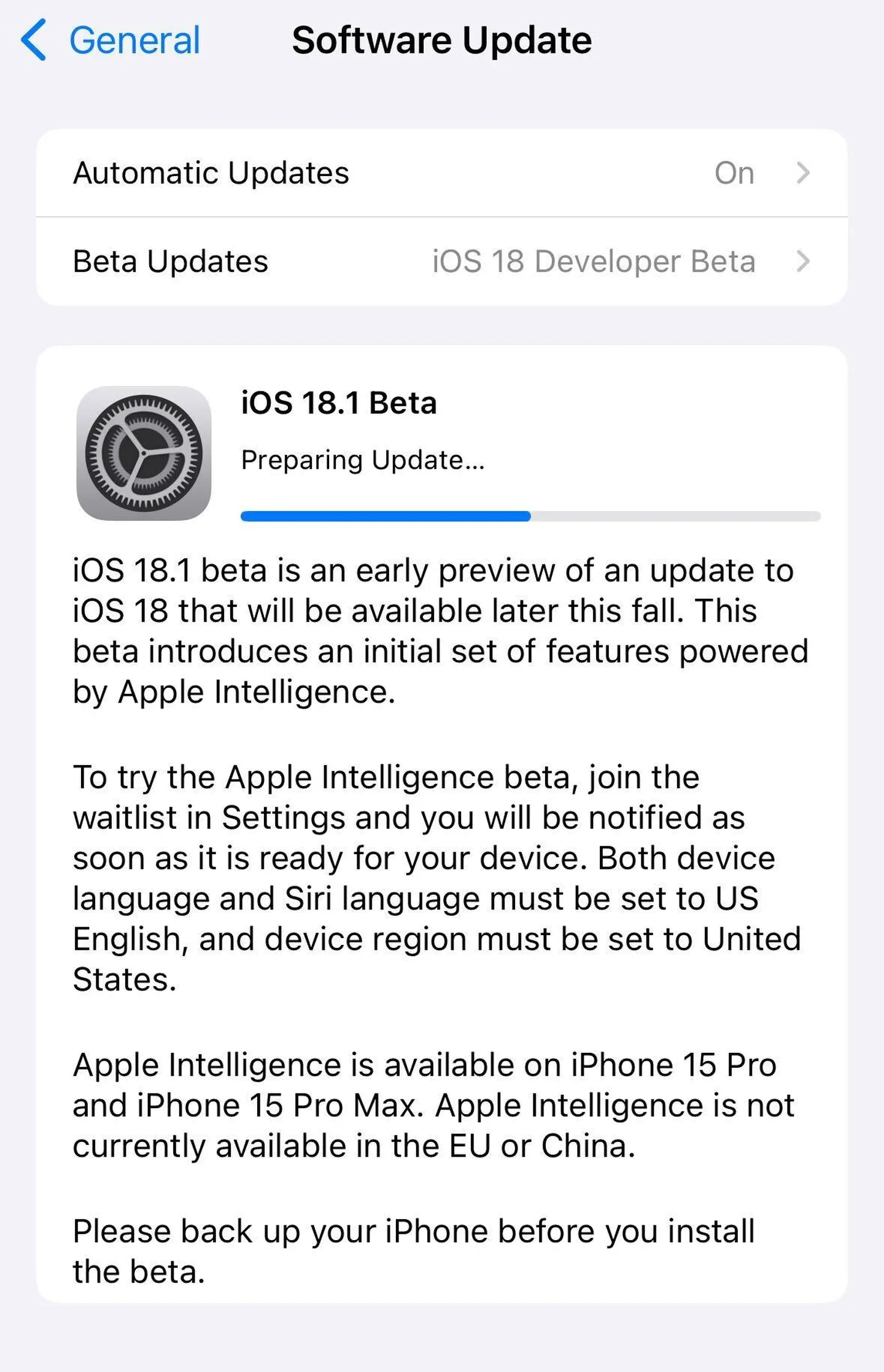

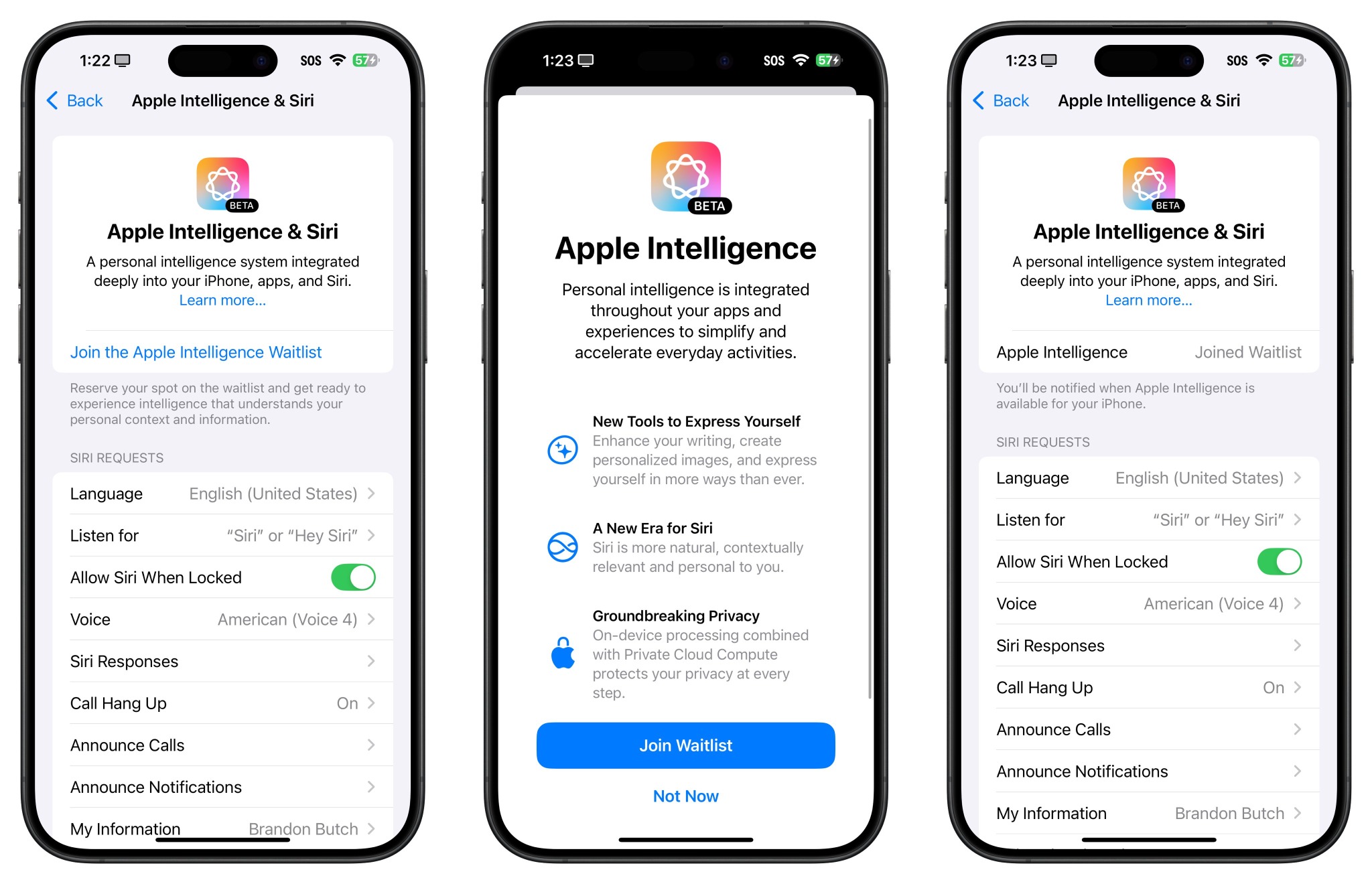

如何下载安装

目前,Apple Intelligence 仅向开发者开放测试,如果你是注册开发者,可以通过以下步骤安装。苹果暂时还没有推出公开测试版,所以想要加入的普通用户目前还需要多等待一段时间。

图源:网络

图源:网络

图源:网络

图源:网络

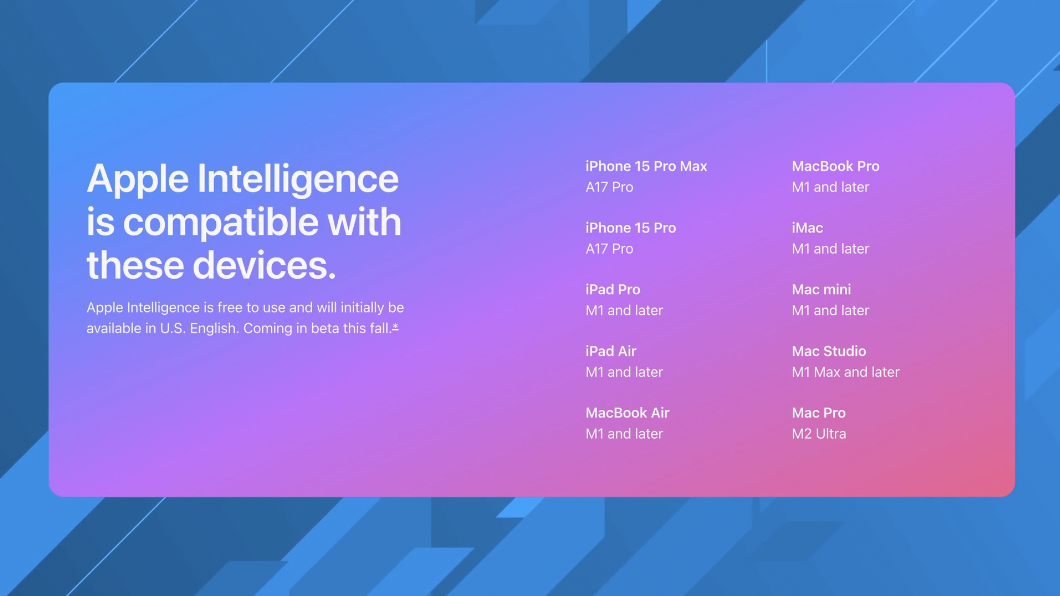

Apple Intelligence 目前仅支持 iPhone 15 Pro、iPhone 15 Pro Max,以及搭载 M1 或更新芯片的 iPad 和 Mac 设备。

图源:网络

图源:网络

使用限制

除了仅支持较新的设备以外,Apple Intelligence 还有以下使用限制:

主要功能

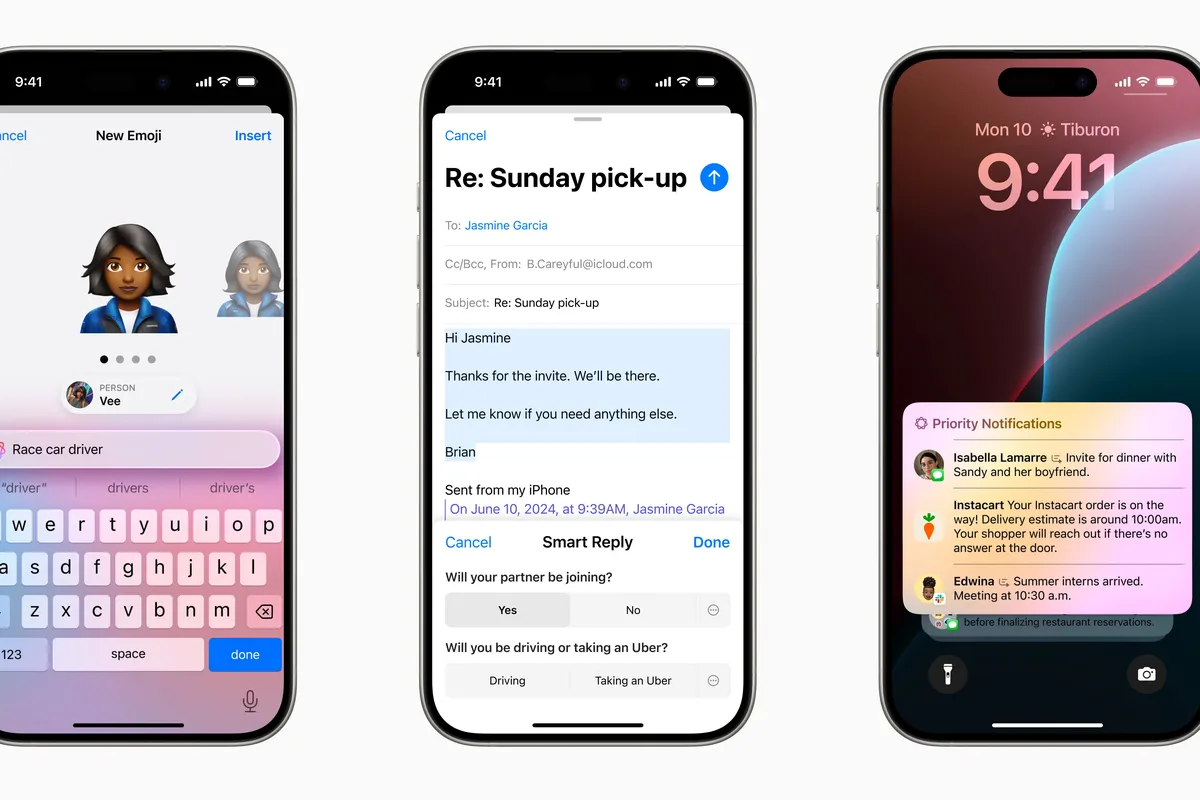

目前已经开放测试的 Apple Intelligence 功能包括:写作工具、升级后的 Siri、邮件智能功能、照片应用增强、转录总结,下面我们将一一介绍这些功能的具体实现。

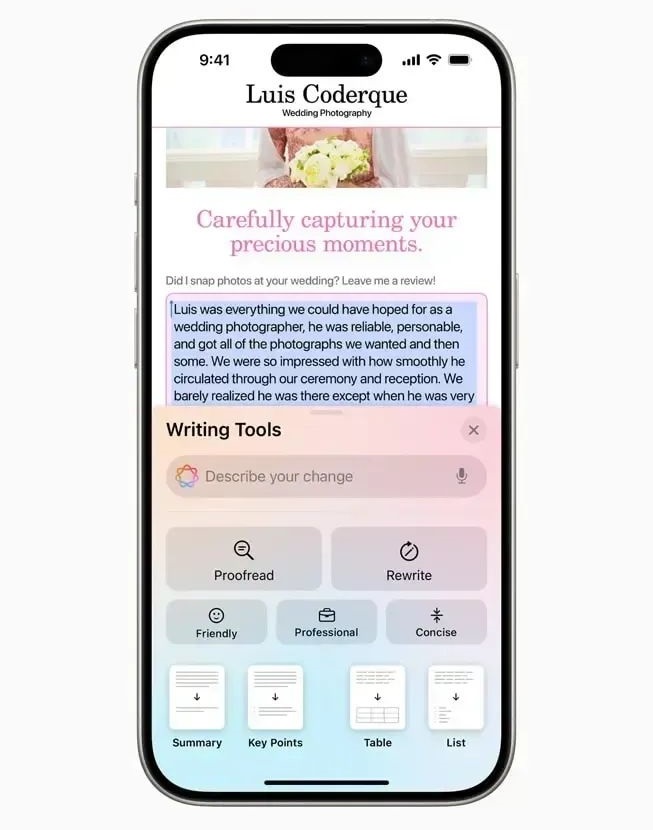

首先是 Apple Intelligence 提供支持写作工具,苹果目前已将其写作工具集成到 iOS、iPadOS 和 macOS 中的标准文本系统中,这就意味不仅邮件、备忘录、Pages 这些苹果第一方的应用程序可以使用这个功能,第三方的应用程序无需适配也同样可以使用这个功能。

要使用新的写作工具,只需选择一些文本,然后在弹出菜单或键盘上方选项中选择「写作工具」。新的写作工具包含:校对、改写、友好的、专业的、简洁的、总结等功能。

图源:网络

图源:网络

经过「友好」改写,F* 开头的粗俗话语被修改成「Strongly disapprove」。

图源:网络

接下来是 Siri,首先映入眼帘的是全新的设计界面,当激活 Siri 时,整个屏幕周围会有一圈光效。其次最大的不同在于 Siri 和你说话的方式,如今它是一种更像对话的语气,听起来少了一些机器人的生硬感,更偏向真人。

在测试中也能发现,目前 Siri 已经能在很多场景测试中直接向用户展示最终结果。当然,目前版本的 Siri 并非完全体,也没有获得 ChatGPT 加持,在一些特定情况下还是只会提供网页链接,用户需要自己寻找答案。

从视频还能看出,新版 Siri 支持在语音和文字两种输入方式之间切换,长按电源键可以激活语音输入,双击底部触控条则可以使用文字输入(以往只能二选一)

图源:网络

图源:网络

第三个获得 AI 加持的应用是邮件,不过邮件中的 AI 功能与写作工具有部分重叠,包括智能回复邮件、生成邮件摘要和优先显示紧急邮件,总的来说都是帮助我们节省时间的好功能

图源:网络

图源:网络

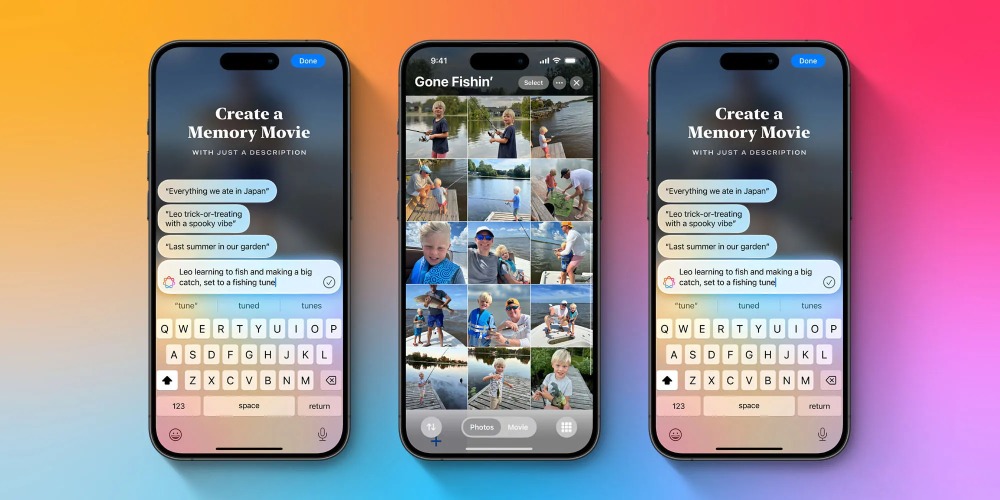

接下来就是照片应用的增强,新功能包括自然语言搜索照片、支持视频内容搜索,AI 生成回忆视频。在当前的系统版本中,从图片中删除不需要的物品和对象的功能暂时还没上线。

图源:网络

图源:网络

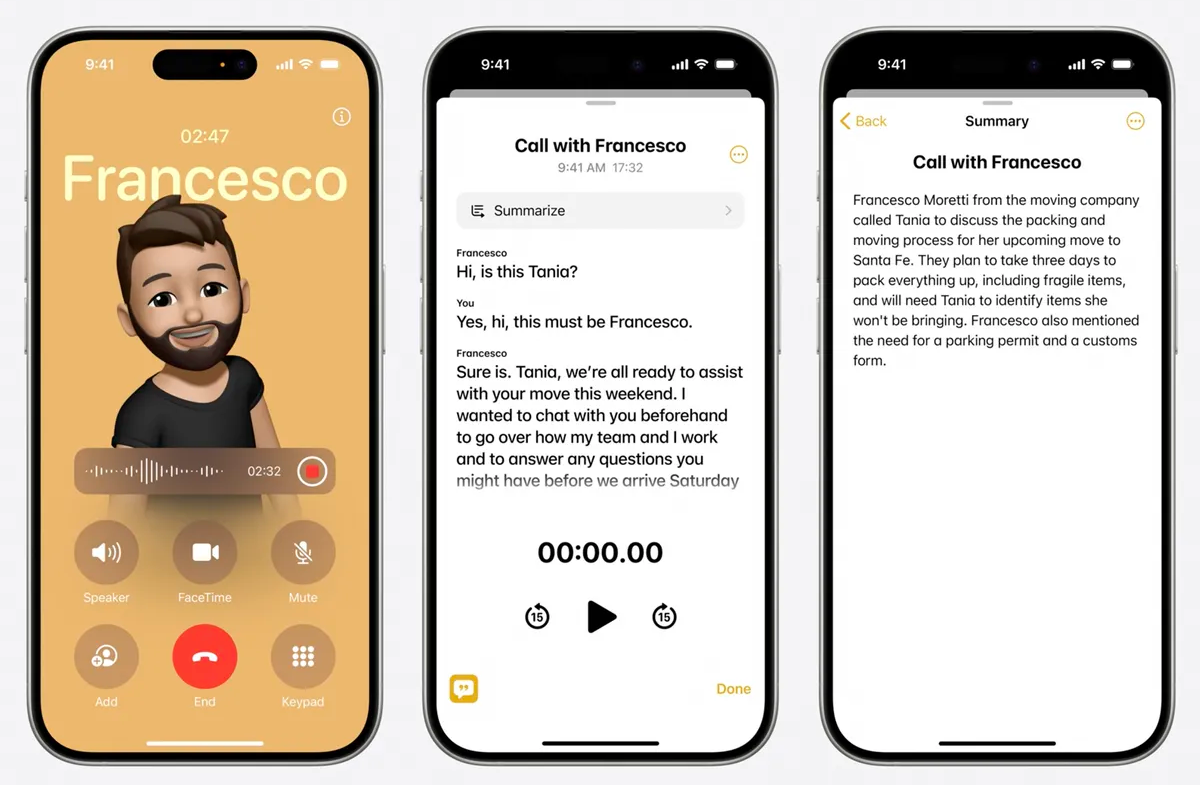

最后就是很多国内用户期待的电话录音功能,通话时,用户点击左上角的新增录音键,就能开启录音,同时对方的电话里面也会收到录音已开启的语音提示。设备会将录音和转换后的文本存储在用户的备忘录中,还能一键为语音转录内容生成摘要。

尚未实现的功能

上述这些功能只是 Apple Intelligence 的部分功能,还有很多苹果在 WWDC 2024 上公布的功能在当前版本中暂未实现,其中就包括:

图源:苹果

图源:苹果

苹果表示,这些功能将在未来一年内陆续推出,也就是说完整版的 Apple Intelligence 可能还需要等到 2025 年才能真正实现。

技术细节

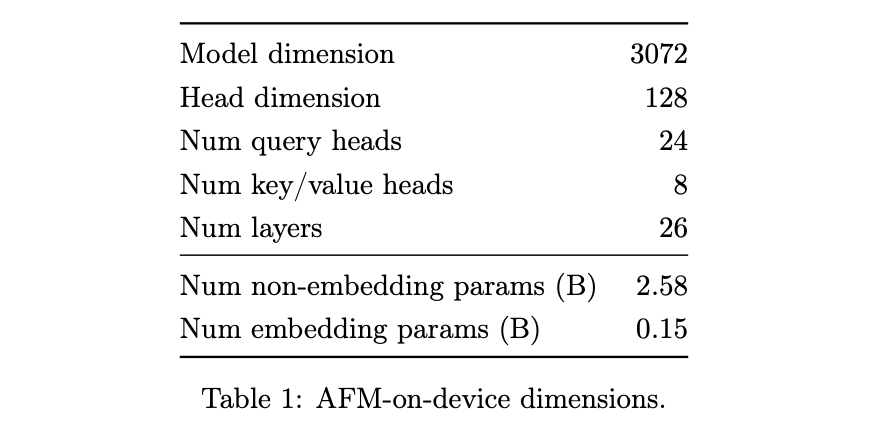

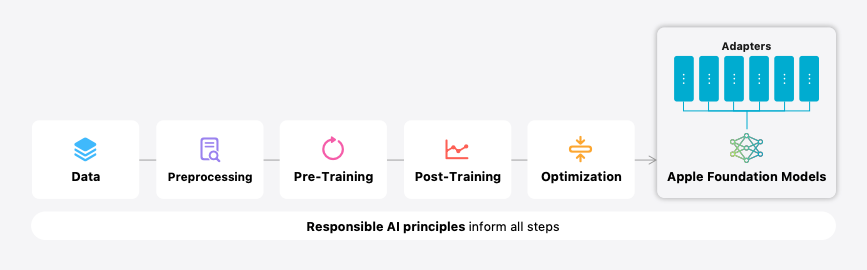

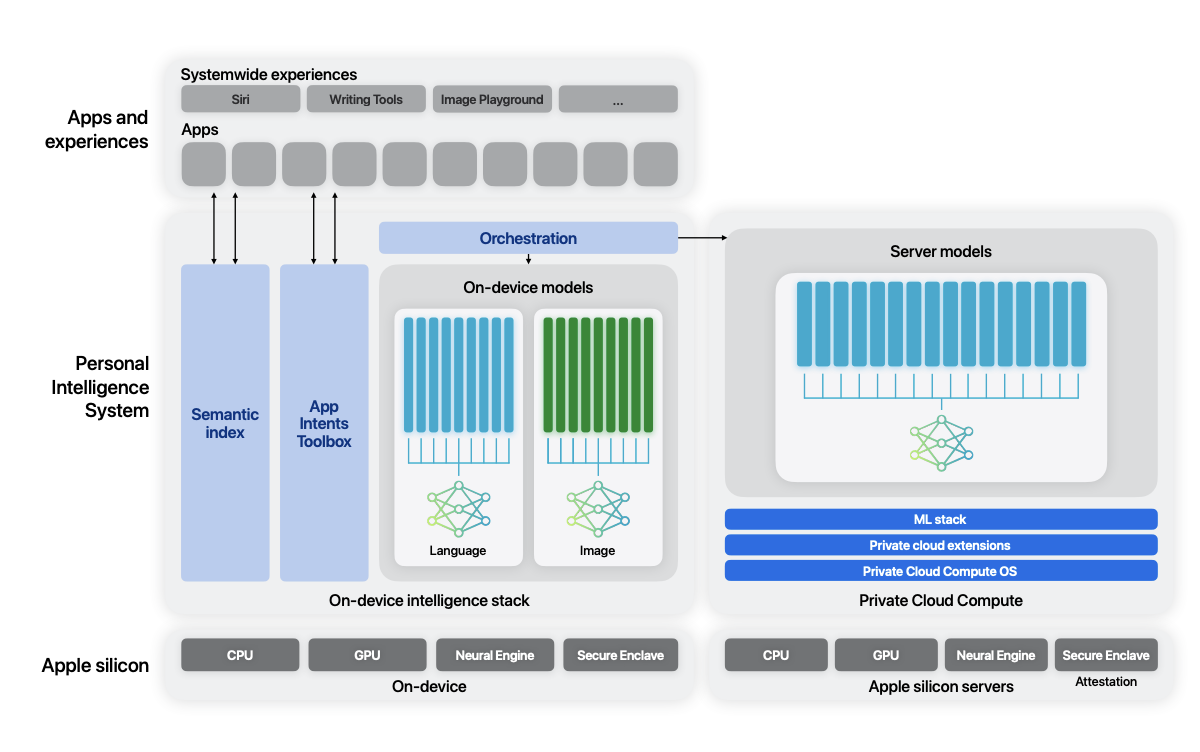

在发布开发者测试版的同时,苹果还一同发布了一份研究论文,论文中详细介绍了他们开发的两个基础语言模型:AFM-on-device(约 30 亿参数,设计用于设备上运行)和 AFM-server(更大的服务器端模型,参数未知)。这两个模型是为了支持 Apple Intelligence 系统而设计的,该系统集成在 iOS 18、iPadOS 18 和 macOS Sequoia 中。

图源:苹果

图源:苹果

在模型架构方面,苹果采用了基于 Transformer 的密集解码器模型,但做了多项创新性改进。例如,他们使用共享的输入/输出嵌入矩阵来减少参数内存使用,采用预归一化和查询/键归一化来提高训练稳定性。特别值得注意的是,他们使用了分组查询注意力(GQA)机制,这有助于减少 KV 缓存的内存占用。同时,他们选择 SwiGLU 作为激活函数以提高效率,并使用 RoPE 位置编码来支持长上下文处理。这些设计选择都体现了苹果在模型效率和性能方面的深思熟虑。

图源:苹果

图源:苹果

在训练数据方面,苹果展现了对数据质量和隐私的高度重视。他们的数据来源包括授权的出版商数据、精心策划的公开数据集以及通过 Applebot 爬取的网络数据。值得强调的是,苹果明确表示没有使用任何用户私人数据进行训练。他们对数据进行了严格的处理,包括质量过滤、去重、安全检查和隐私保护。例如,他们使用启发式方法和基于模型的分类器进行安全和质量过滤,并采用全局模糊去重技术。这种严谨的数据处理方法反映了苹果对用户隐私的承诺和对模型质量的追求。

训练过程分为三个主要阶段:核心预训练、持续预训练和上下文延长。在核心预训练阶段,AFM-server 从头开始训练,而 AFM-on-device 则通过从更大模型蒸馏得到。这种方法使得小型设备模型能够获得接近大型模型的性能。在持续预训练阶段,他们调整了数据混合比例,增加了数学和代码数据的权重。最后的上下文延长阶段旨在提高模型处理长序列的能力。

苹果还详细介绍了他们的后训练过程,包括监督微调(SFT)和基于人类反馈的强化学习(RLHF)。他们提出了一种新的 RLHF 算法 MDLOO,这种方法在实践中表现出更好的稳定性和性能。

图源:苹果

图源:苹果

为了使模型能够适应不同的任务,苹果采用了基于 LoRA 的适配器架构,可以动态加载和切换,使单个基础模型能够灵活地适应数十种不同的任务。这种设计大大提高了模型的能力,同时保持了高效率。

图源:苹果

图源:苹果

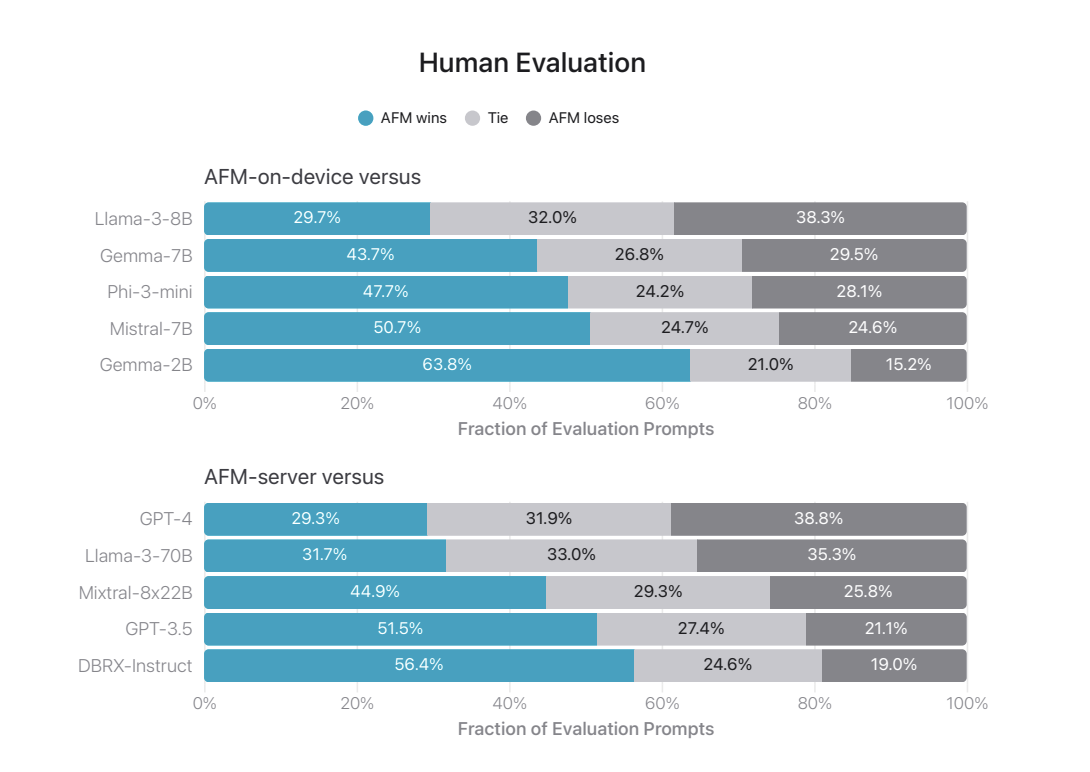

在模型评估方面,苹果进行了全面的测试,包括公开基准测试和大量人工评估。结果显示,他们的模型在多个方面表现优异,特别是在指令跟随、工具使用和写作能力方面。值得注意的是,他们的小型设备模型 AFM-on-device 在某些任务上甚至超过了参数量更大的开源模型。

图源:苹果

图源:苹果

最后,苹果强调了他们在负责任 AI 开发方面的努力。他们制定了全面的安全分类和政策,在模型开发的每个阶段都考虑到了伦理和安全问题。他们进行了广泛的红队测试,并建立了持续改进的机制。这反映了苹果在追求技术进步的同时,也高度重视 AI 的社会影响和道德问题。

结语

Apple Intelligence 的推出标志着苹果正式进军 AI 领域。虽然目前功能还不够完善,但苹果承诺将持续优化和扩展。对于用户来说,这意味着我们的 iPhone、iPad 和 Mac 设备将变得更加智能和高效。但对国内用户来说,何时可以用上 Apple Intelligence,以及苹果会选择与国内的哪家公司合作,目前一切都是未知。

投稿/爆料:tougao@youxituoluo.com

稿件/商务合作: 六六(微信 13138755620)

加入行业交流群:六六(微信 13138755620)

版权申明:本文为VR陀螺原创,任何第三方未经授权不得转载。如需转载请联系微信:vrtuoluo233 申请授权,并在转载时保留转载来源、作者以及原文链接信息,不得擅自更改内容,违规转载法律必究。文中有图片、视频素材来自互联网或无法核实出处,如涉及版权问题,请联系本网站协商处理。

元宇宙数字产业服务平台

下载「陀螺科技」APP,获取前沿深度元宇宙讯息